27 August, 2021

Этот текст опубликован до 24 февраля 2022 года.

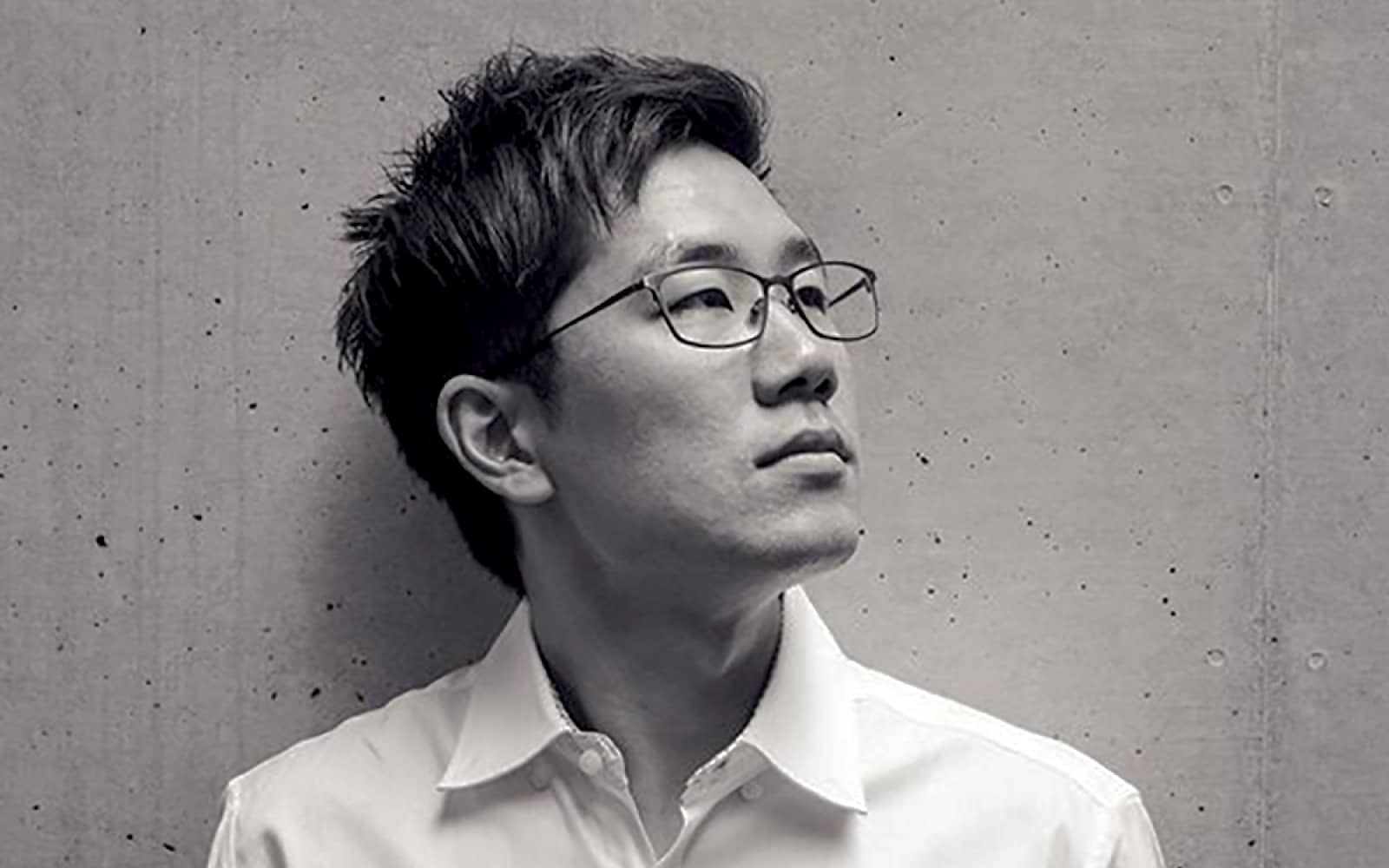

Наша повседневность сегодня насыщена контактами с умными устройствами, а в руках у IT-компаний — большие данные практически по любым темам. Что происходит со знаниями в этот исторический момент? Что если приравнивание данных к знанию приводит к новым формам спекуляций? В своей книге «Технологии спекуляции: ограничения знания, основанного на данных» (2020) медиаисследователь Сан Ха Хонг ищет ответы на эти вопросы, всматриваясь в разногласия вокруг технологий слежки и устройств для самоизмерений. В интервью для сверхновой независимый социальный исследователь технологий Дмитрий Муравьев говорит с Сан Ха Хонгом о том, могут ли данные помочь людям узнать себя лучше и сблизиться с другими, а также почему дискуссии о выборе между свободой и информацией непродуктивны.

Дима Муравьёв

В своей книге вы отвечаете на интересный и сложный вопрос о том, что считается знанием в век больших данных и умных машин. С чего начался ваш личный и профессиональный интерес к этой теме?

Сан Ха

С теоретического вопроса: «Что такое факт?». Когда говорят о том, что технология помогает предугадать возможные правонарушения или определить рабочую продуктивность, как это влияет на определение «факта»? Можно ли устранить неопределенность и двойственность терминов?

Со временем я начал понимать, что это возможно, но только через насилие — так я сместил свой фокус на вопросы о власти. Существует популярная и соблазнительная идея, будто данные говорят сами за себя. Например, если человек получил высокий балл после прохождения опросника LSI-R ※, это дает тебе основания арестовать его. Но это лишь ограниченная правда, та, что определяется конкретным тестом. Кто выбрал эти категории? Можно ли вообще свести человеческий опыт к обобщенным категориям?

※ LSI-R — стандартизированное и количественное анкетирование правонарушителей о их жизненном положении, использующиеся для определения уровня надзора и надлежащего обращения.

На каждом этапе принимается так много решений, что было бы ошибкой думать об этом исключительно как об интеллектуальной проблеме, как о грандиозном поиске истины, которую мы найдем, если разложим личность человека по верным параметрам. Такая логика дает возможность, столкнувшись с предвзятостью алгоритма и вредоносными технологиями, считать их лишь побочными эффектами.

На мой взгляд, дело обстоит ровно противоположным образом. Например, в США за наблюдением, профилированием и тюремным заключением чернокожих людей всегда стояли очень мощные экономические и политические силы. Неравенство и существующие иерархии никуда не исчезают при появлении новой технологии. Даже напротив: все те же силы финансируют, разрабатывают и внедряют инновации — тем самым только укрепляя собственные позиции.

Предполагается, что технологии должны принести нам будущее, но они часто повторяют и поддерживают гегемонию прошлого.

Дима Муравьёв

Здесь мы подходим к противоречию между обещаниями технологии и условиями, в которых она создается и распространяется. Мне любопытно, поменял ли опыт написания книги ваши собственные практики жизни вместе с технологиями?

Сан Ха

Для меня главные изменения были не в практиках, а в самом отношении к технологиям — я имею в виду доверие к ним и желание обладать ими.

Я рос в семье бедных иммигрантов и не мог позволить себе завести хобби, отправиться в путешествие или потреблять медиа — это было слишком затратно. Тогда интернет стал для меня воплощением надежды: я мог испытать что угодно, почти без ограничений и затрат.

Я рос в 1990-е годы, когда казалось, что история закончилась. В то время многие воображали, будто больше не будет идеологической борьбы и войн. Это видение мира, где технологии и наука были единственным, что могло избавить людей от страданий — без веры в них не было будущего. Тут мне вспоминается высказывание, которое я однажды услышал: «Мы верим во что-то не потому что это верно, а из-за того, что все важные для нас вопросы и ответы завязаны на эту веру. Если мы ее потревожим, то все остальные наши убеждения начнут распадаться».

Отношение к технологиям поменялось за последние пять лет — и полагаю, так случилось не только у меня, но и у многих других. Во многом это связано с техлэшем (в ориг. techlash; сильная негативная реакция на растущую силу и влиятельность крупных технологических компаний, их сотрудников или продукции). Ситуация сложнее, чем личный выбор между iOS и Android — сама структура технологических систем, с которыми мы ежедневно взаимодействуем, обесценивает значимость таких индивидуальных решений. Предположим, я удалю свой аккаунт в Facebook, но это не помешает компании отслеживать мои действия с помощью трекеров и других сторонних приложений.

Но есть ли у нас на самом деле выбор, верить в технологию или нет? Я так не думаю. Для многих она была и остается единственной надеждой на то, что социальная ситуация, в которой мы живем, может измениться в лучшую сторону.

Вопрос в том, какие идеи и нарративы доступны — в отсутствии альтернатив мы в итоге любим технологию и защищаем ее, даже если она продолжает нас разочаровывать.

Дима Муравьёв

В книге вы касаетесь тех смыслов, которыми исторически наделялись большие данные и алгоритмы — их считали объективными, нейтральными, точными и истинными. Является ли эта мифология чем-то принципиально новым или наследует смыслам, присущим пониманию технологий прошлого?

Сан Ха

Технологический утопизм похож на американский ситком: есть новые эпизоды с шутками каждую неделю, но все они похожи друг на друга. В том, как мы говорим о наблюдении и приватности, данных и объективности, есть большая степень преемственности и повторяемости.

Так, недавно Илон Маск сказал, что искусственный интеллект сделает человеческие языки ненужными через пять лет. Он просто не понимает, что повторяет старую шутку Рэймонда Курцвейла, еще одного технологического пророка, по утверждению которого, машины должны были стать самоуправляемыми в 2009 году. А Марвин Минский, ранний пионер искусственного интеллекта, обещал умные машины еще к концу 1970-х. Мы имеем дело с постоянной переработкой одной и той же фантазии о будущем, похожей на еженедельную церковную проповедь.

И это фантазия о полностью просчитанном мире. У нее долгая история, еще французские энциклопедисты XVIII века предлагали создать единый архив человеческих знаний. Только из подобной фантазии ускользает вопрос о том, кому нужен просчитанный и точный мир? Здесь важно всегда держать в уме различие между субъектом и объектом подсчета.

Дима Муравьёв

Это приводит нас к теме «интимности данных» (термин из книги Хонга — прим. сверхновой). Несколько упрощая, ваш аргумент заключается в том, что в современном мире практически все аспекты нашей жизни становятся данными и эксплуатируются для коммерческих целей. Возможно ли представить себе интимные отношения с данными без подобной эксплуатации?

Сан Ха

Мы на самом деле не знаем, что такое интимность. В книге я пишу о трекерах психологического состояния и физической активности пользователей. Такие технологии якобы должны помочь нам узнать себя лучше, стать ближе к своему «истинному» я. Конечно, при этом предполагается, что данные будут полностью подчинены нашему свободному выбору.

Это очень привлекательное обещание, потому что оно обращено к нашему утопическому желанию самоконтроля и свободы. Мы думаем: «Если бы я точно знал, насколько продуктивен, сколько времени я провожу с друзьями и в смартфоне, то смог бы жить именно так, как мне хочется». Это мечта о точном знании.

Я предлагаю другое понимание интимности. Компасом в этой теме для меня долгое время были тексты Лорен Берлант. Она как-то написала: «Не иметь представления о том, как все закончится, — вот секретная эпитафия интимности». Для нее попытка понять другого связана с готовностью удивляться и показывать свои уязвимости. Только так мы сталкиваемся с чем-то неожиданным в себе. То же самое происходит, когда мы заняты самопознанием.

В моем представлении интимность плохо сочетается с объективностью — если первая предполагает уязвимость и неожиданные встречи, то вторая связана с неизменной точностью. Если технология действительно способна помочь нам в самопознании, то машины должны быть сопутствующим элементом этого процесса, а не центральным.

Дима Муравьёв

Сегодня во всем мире идут дискуссии о повсеместности слежки. При этом обсуждение слежки часто оформляется как необходимость сбалансированного выбора между свободой и безопасностью. Что вы думаете о такой постановке вопроса, кажется ли вам она удовлетворительной?

Сан Ха

Нет (смеется). Доминирующий сейчас нарратив и модель компромисса ошибочны: тут создается конфликт с нулевой суммой между свободой и безопасностью. Такая модель никогда не находила подтверждения: это словно сказать, что чем больше вы любите свою маму, тем меньше вы любите папу.

Есть три фундаментальные проблемы с такой моделью. Во-первых, фактическая. Ни свобода, ни безопасность не поддаются измерению — сложно определить, какой объем технологий для слежки действительно необходим, чтобы снизить количество преступлений или террористической активности. Есть известный кейс: после 11 сентября правительство Нью-Йорка потратило миллионы долларов на системы видеонаблюдения в метро. По прошествии 10 лет до сих пор неясно, сколько преступлений она помогла предотвратить, так как такого рода эффект сложно отделить от работы правоохранительных органов в целом.

После разоблачений Сноудена правительство США утверждало, что слежка Агенства национальной безопаности (АНБ) помогла предотвратить около 54 актов терроризма, однако детали были предоставлены лишь по четырем из них. Может создаться впечатление, будто идея компромисса моделирует ситуацию математического уравнения, однако, на самом деле, в это уравнение мы подставляем воображаемые цифры.

Во-вторых, есть нормативная проблема. Даже если бы мы знали эти цифры, какой ответ был бы в этом уравнении? Сколько нужно заплатить в гражданских свободах, чтобы предотвратить, к примеру, 10 террористических актов? Такое мышление сформировалось в результате переосмысления категории рисков и института страхования. Оно сводится к идее о том, что управление опасностями возможно, только если перевести их в деньги. Это довольно ограничивающий тип мышления.

В-третьих, есть важная практическая проблема. В действительности обращение к модели компромисса не приведет к объективному, взвешенному анализу затрат и выгод. В подавляющем большинстве случаев люди используют модель компромисса для оправдания мер, продвигающих безопасность.

Так происходит отчасти потому, что данные, помогающие обосновать усиление наблюдения, часто очень заметны и продвигаются влиятельными институтами. Например, когда Сноуден выгрузил в интернет засекреченные документы, и слежка АНБ подверглась критике, генералы, сенаторы и сам президент Барак Обама заполонили эфирное время, чтобы защитить агентство.

По крайней мере, в США всегда легче найти подробные данные о преступности, чтобы оправдать увеличение расходов на полицию, технологии подчинения. С другой стороны, полицейские профсоюзы активно пытаются скрыть и уничтожить данные о полицейском насилии и неправомерных действиях полиции.

Таким образом, существует асимметрия в том, какая информация доступна для принятия решений. Получается, что когда люди говорят о компромиссе, это обычно ведет к оправданию технологий слежки, ведь никто не хочет утверждать, что любой уровень терроризма или преступности это «нормально».

Дима Муравьёв

В вашей книге есть интересное прочтение разоблачений Сноудена. Можете ли вы объяснить концепт «рецессивных объектов», который описывает, как «вещи, обещающие расширить наши возможности познания, одновременно с этим становятся катализаторами спекуляций и сомнений»?

Сан Ха

Каждый раз сталкиваясь с новой информацией или технологией, например, с распознаванием лиц, мы полагаем, что именно она наконец поможет нам уменьшить неопределенность. Но это похоже на мираж в пустыне: тебе кажется, что ты подобрался совсем близко — а объект снова маячит где-то вдали.

Думаю, лучше всего эту проблему описала антрополог Мэри Дуглас: по ее наблюдению, когда люди не соглашаются друг с другом, они думают, что все дело в недостатке информации. Такая же ситуация сейчас происходит с фейковыми новостями. Многие думают: если мы дадим людям больше данных, то они точно дойдут до истины.

Проблема в том, что информация может порождать спекуляции. Мы видели это на примере разоблачений Сноудена, когда огромное количество данных о технологиях слежки стало доступно обществу, став почвой для новых теорий и домыслов о возможных масштабах наблюдения. То же самое — с коронавирусом: сложная и детализированная информация о скорости распространения или вакцинах превращалась в источник очередного недопонимания, возникавшего по ошибке или искусственно спровоцированного.

В своей книге я пишу о том, что одной прозрачности недостаточно. Нужно не только информировать общество, необходимо также разработать механизмы для защиты информации от недобросовестных интерпретаций. Обычно мы ждем этого от журналистики, и тот факт, что СМИ в США находятся в критическом экономическом положении, — далеко не случайность. И, к сожалению, финансовый кризис лишает прессу возможности выстроить подходящую архитектуру для распространения информации.

Дима Муравьёв

Получается, вы выступаете за курирование данных?

Сан Ха

В прозрачности самой по себе нет ничего плохого, часто она необходима. Я бы хотел прояснить — по моему мнению, Эдвард Сноуден оказал большую услугу гражданским правам и гражданским свободам в США и во всем мире. Я лично не знаю, можно ли было сделать лучше. Для меня дилемма скорее в том, что происходит, когда отдельному субъекту или обществу в целом приходится как-то обрабатывать всю эту информацию.

Идеалом прозрачности часто злоупотребляют, перекладывая ответственность на отдельных людей. Условия предоставления услуг (Terms of Service) — очевидный пример. Вот вы решили создать аккаунт на Facebook, прочитали невыносимо длинное пользовательское соглашение и приняли его. А потом вам говорят, что это ваша обязанность — разобраться в том, как работают подобные сложные платформы. Если что-то пойдет не так, то, опять же, решение проблемы зависит от ваших действий — от того, готовы ли бросить вызов и подать в суд на богатую транснациональную компанию, которая сделает все, чтобы остановить вас.

Ключевой вопрос заключается не в том, кто курирует информацию, а в том, кто несет ответственность за ее распространение. Должен ли это быть журналист? Правительство? Я думаю, ответственность нельзя перекладывать на отдельного человека.

Дима Муравьёв

Хочется вернуться к теме данных и обсудить такой тезис: чтобы избежать ошибок, связанных с обработкой данных, нужно собрать еще больше данных. В частности, технологию распознавания лиц критикуют за то, что в нее вшиты предубеждения против определенных социально-демографических групп. Более разнообразные наборы информации, на которой разработчики тренируют алгоритмы, помогли бы решить эту проблему. Что вы думаете на этот счет?

Сан Ха

Такая логика устроена абсолютно магически, так как предполагает скорее совершенствование, а не изменение технологий. Будто, если мы дадим больше данных, времени, денег и власти разработчикам, тогда все проблемы исчезнут. Взять к примеру технологию распознавания лиц, которую сейчас используют для поимки преступников и даже определения сексуальной ориентации или эмоционального состояния человека. Мы верим в то, что она работает. Однако утверждение, что черты лица способны рассказать о склонности к совершению преступлений, сексуальности или эмоциях, научно не подтверждено.

Отличается ли технология распознавания лиц от дискредитировавших себя научных предприятий прошлого — например, френологии? Доказательств нет, есть только демонстрация корреляции: посмотрите на систему машинного обучения, которая учла множество факторов и теперь способна правильно помечать изображения людей. В такой логике любая обнаруженная взаимосвязь может быть оправдана.

Например, представьте, что компания, занимающаяся разработкой искусственного интеллекта, скажет: «Мы будем измерять микро-вибрации в головах людей и использовать эти данные, чтобы понять, является ли человек преступником». Это звучит нелепо, но я описываю реальную компанию и продукт под названием Vibra image. Его уже опробовали на чемпионате мира по футболу и саммите G7. Это как в старой шутке из Симпсонов, когда Гомер Симпсон делает одну и ту же глупую вещь снова и снова, ожидая другого результата. Ирония заключается в том, что некоторые из наших самых богатых и передовых технологических компаний пытаются внушить нам, что Гомер Симпсон был прав. И это очень опасно, потому что отвлекает от более рационального понимания проблем, связанных с искусственным интеллектом.

Дима Муравьёв

Напоследок я бы хотел спросить про будущее. Маркетинг новейших технологий, как мы с вами обсудили, построен на обещании непреодолимого будущего, которое обязательно наступит и положительным образом поменяет мир. Кажется ли вам, что подчеркивание неизбежности технологического прогресса само по себе неизбежно?

Сан Ха

Я бы скорее сказал, что технологическая индустрия отчаянно нуждается в этом мифе о неизбежности. Иначе компаниям пришлось бы признать неспособность выполнить многие из своих обещаний.

Эти корпорации и их руководители невероятно некомпетентны. Вот, например, компания Uber, которая никогда не была прибыльной — она часто теряла миллиарды долларов каждый квартал. Для успеха бизнеса нужна была фантазия о том, что гиг-экономика и самоуправляемые автомобили неизбежны. Без этого мифа Uber не стал бы такой большой и могущественной компанией, какой он является сегодня.

Именно поэтому культура фантазий постоянно изобретает новые войны и образы, чтобы повторять одно и то же пророчество. Помните, в 2012 году «большие данные» были еще довольно новым словом, которое считалось революционным? Через пять лет термин уже надоел, и мы заменили его искусственным интеллектом (ИИ). Хотя, опять же, большинство вещей, которые описывают термином «искусственный интеллект», по сути, представляют собой «глянцевые» версии статистических методов, имеющих очень мало общего с тем, что мы представляем себе под ИИ.

Проблема тут не только в том, что будущее откладывается. Каждый раз, когда оно перерабатывается, мы крадем время у нашего настоящего. В другой своей работе «Технобудущности в стазисе: умные машины, повсеместные вычисления и будущее, которое продолжает возвращаться» я использую образ зала ожидания как метафору. Нам постоянно говорят ждать в этой комнате, пока славное будущее находится по ту сторону двери. Но дверь никогда не откроется. Она всегда заперта. Это как ворота в "Процессе" Кафки, через которые мы никогда не сможем пройти. И вот, мы все смотрим через замочную скважину на прекрасное кинематографическое изображение. Мы видим летающие машины и умных роботов, но забываем о том, что все еще находимся в зале ожидания, где гниют наши города, общества и тела.

Все всегда говорят мне, что это так удручающе: «Неужели у вас нет решения или надежды для нас?» А я всегда отвечаю: нам нужно очень глубоко понять проблемы, прежде чем мы сможем найти правильное решение. Если мы слишком рано подарим себе надежду, то совершим те же ошибки — именно так поступают разработчики технологий сейчас. Они говорят нам, что все будет в порядке, не стоит терять веру, с новой технологией все решится. Но такая надежда по-настоящему опасна.