Этот текст опубликован до 24 февраля 2022 года. У него есть автор, но из соображений безопасности мы называем не все имена.

В обычной жизни мы воспринимаем катастрофы, грозящие гибелью всему живому, как троп массовой культуры. Любой вспомнит хотя бы несколько сюжетов о зомби-апокалипсисе, восстании роботов или нашествии инопланетян. И если творческие личности с охотой делятся своими предсказаниями и образами, то о том, как ученые работают над прогнозами пугающего будущего и какие шаги предпринимают, чтобы трагедию предотвратить, мы мало что знаем. Участник СОЮЗа собрал для Сверхновой материалы об Институте будущего жизни, где как раз занимаются изучением и оценкой глобальных рисков.

Кто, где, когда

Институт будущего жизни (далее — FLI) был основан в 2014 году физиком, космологом и исследователем искусственного интеллекта (далее — ИИ) Максом Тегмарком. Там изучают глобальные экзистенциальные риски — то есть сценарии будущего, приводящие к исчезновению человечества. FLI дает гранты на исследования рисков, связанных с ИИ, а также занимается просветительскими и активистскими программами по проблемам ядерного вооружения, биотехнологий и глобального потепления.

Из-за того что Тегмарк активно указывал на опасности, которые несут с собой технологии, на него успели навесить ярлык «неолуддита». На самом деле главная идея многих его сочинений и выступлений состоит в том, что технологический прогресс нельзя пускать «на самотек». Технологии могут решить множество проблем человечества, но только при условии наблюдения и контроля со стороны общества.

FLI — не единственный и не первый проект такого рода. Над теми же проблемами трудятся в основанном философом Ником Бостромом Институте будущего человечества, кембриджском Центре исследований экзистенциальных рисков, Институте глобальных катастрофических рисков и шведском Фонде глобальных вызовов. Однако именно Тегмарку лучше всего удается вести диалог между передовыми представителями академического сообщества, исследователями ИИ, экономистами, правоведами, философами и лидерами ИТ-индустрии: DeepMind, Google, Facebook, Apple, IBM, Microsoft и Baidu.

Помимо Макса Тегмарка среди основателей Института будущего жизни числятся его жена Мэйя Чита-Тегмарк, исследовательница взаимодействия между людьми и роботами, космолог Энтони Агирре, исследовательница безопасного ИИ из DeepMind1. Виктория Краковна и создатель Skype Ян Таллинн, ставший первым инвестором проекта.

Широкое внимание к FLI привлек Илон Маск, пожертвовав ему 10 млн долларов на исследования безопасного ИИ в 2015 г.

Премия «Будущее жизни»

Человечество уже давно вошло в эпоху экзистенциальных рисков. Мы на той стадии прогресса, когда наши действия могут привести как к самоуничтожению, так и к уничтожению всей жизни на Земле. Премия «Будущее жизни» была учреждена в 2017 году, чтобы отметить вклад людей, сумевших предотвратить глобальную катастрофу.

Первым лауреатом посмертно стал Василий Архипов, а чуть позже награду вручили Станиславу Петрову. Оба служили в советских войсках, и каждый из них однажды принял решение, благодаря которому человечеству удалось избежать атомной войны. Первый — во время Карибского кризиса, второй — 20 лет спустя.

В тот же год, когда была вручена первая премия, FLI выпустил «Открытое письмо ученых в поддержку переговоров в ООН о запрещении ядерного оружия», под которым свою подпись на настоящий момент поставили почти 4000 академиков со всего мира, в том числе 36 лауреатов Нобелевской премии. Хотя сегодня угроза атомного холокоста исчезла из общественной повестки, нельзя забывать, что такой сценарий все еще возможен. Мировой ядерный потенциал составляет примерно 13 100 боеголовок, из которых более 90% принадлежат США и России.

Одним из наиболее обсуждаемых рисков сегодня является экологическая катастрофа. Эта проблема затрагивает интересы такого количества индивидов, корпораций и государств, что иногда закрадывается сомнение в том, сможет ли человечество скооперироваться и справиться с ней. К счастью, есть и вдохновляющие примеры. Так, благодаря активному содействию биолога Мэттью Мезельсона в 1975 году вступила в силу конвенция о биологическом и химическом оружии, утвержденная странами ООН. В 2019 году ученый также стал лауреатом премии «Будущее жизни».

Исследования безопасности ИИ

Искусственный интеллект можно определить как (небиологическую) систему, способную самостоятельно достигать сложных целей. Изучением рисков, связанных с искусственным интеллектом в настоящем и будущем, занимаются специалисты в области AI safety research — это междисциплинарное поле на стыке компьютерной науки, этики, социологии, экономики, юриспруденции и психологии. FLI активно поддерживает исследования в этой сфере.

В последние десять лет началась активная коммерциализация ИИ: от рекомендательных алгоритмов социальных сетей и таргетированной рекламы до систем распознавания лиц и массовой слежки. Рекомендательная система самостоятельно обучается и выдает пользователю посты и ролики, удерживающие его внимание. Чем больше времени человек проведет на сайте, тем больше он посмотрит рекламы. ИИ достигает своей цели на порядок лучше, чем самый утонченный алгоритм, написанный человеком вручную. Такие системы зачастую превращают нас в обитателей «информационных пузырей» — то есть стимулируют пользователей потреблять контент, отражающий исключительно их взгляды и ценности. Пузыри, в свою очередь, приводят к политической поляризации, что уже отразилось на результатах предыдущих президентских выборов в США и референдума по Брекситу. Стоит к этому добавить внедрение систем слежки, позволяющих автоматически анализировать и предсказывать поведение пользователя, — и тут уже недалеко до прямого нарушения прав человека.

Другая опасность связана с автономным летальным оружием, то есть системами вооружения, которые способны самостоятельно идентифицировать цель поражения и «нажать на курок» без участия человека. Здесь ИИ также играет решающую роль. Наше сегодняшнее положение похоже на ситуацию с биологическим оружием 50 лет назад: эти разработки успели привести к трагедии только в ограниченном масштабе, но их последствия могут оказаться катастрофическими. Поэтому очень важно, чтобы государства как можно раньше ввели на них полный запрет. «Обязательство об автономном летальном оружии» на данный момент подписали примерно 3000 человек и 250 организаций.

В будущем опасность, исходящая от ИИ, только возрастет. Если представить, что «сильный искусственный интеллект», многократно превосходящий людей по уровню знаний и возможностей, станет реальностью, какими могут оказаться последствия? Приведем в пример мысленный эксперимент, предложенный Ником Бостромом. Дадим сильному ИИ цель увеличить объемы производства на фабрике бумажных скрепок. Откуда нам знать, что он не уничтожит человечество, реорганизовав все атомы, из которых состоит планета, в гигантскую фабрику скрепок? Как объяснить ИИ человеческую этику, удостовериться, что он ее понял и заинтересован в том, чтобы действовать в ее границах? И кстати говоря, какие именно взгляды на этику нужно будет в него закладывать, по Канту или по Миллю, типичные для западного человека или восточного? Эти вопросы сложны сами по себе и порождают еще больше трудностей, когда исследователи пытаются придумать техническое воплощение того или иного решения.

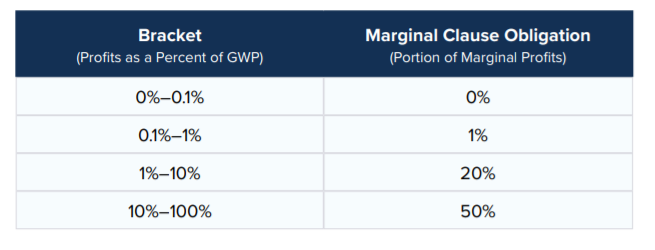

А теперь представьте себе мир будущего, где разные социальные агенты (люди, корпорации, государства) будут взаимодействоватьс разными искусственными интеллектуальными агентами. При таком раскладе ситуация становится еще более запутанной. В FLI об этом тоже подумали и создали The Windfall Clause — договор между корпорациями, которые активны в секторе ИИ. Если сильный искусственный интеллект займет большинство рабочих мест на планете, скорее всего доходы этих компаний составят значительный процент от мирового ВВП. В таком случае подписавшиеся будут обязаны распределить между жителями планеты определенную долю своего маржинального дохода (по сути, обеспечивая всемирный безусловный доход).

Наконец, главная и самая известная инициатива FLI — «Асиломарские принципы», 23 пункта, которых должно придерживаться человечество при разработке ИИ. Этот документ объединил исследовательское сообщество и получил всеобщее признание.

Новые глобальные риски настолько же реальны, как и те, к которым мы «привыкли», и будем надеяться, их мы тоже сможем предотвратить. Только для этого главы государств и корпораций, ученые и общество должны найти общий язык, договориться о безусловных этических ценностях и табу. Институт будущего жизни — один из проектов, которые стремятся установить международные нормы для нашего безопасного и устойчивого будущего.

1 DeepMind — одна из ведущих лабораторий ИИ в мире, занимающаяся исследованиями и разработками в машинном обучении и проблемой сильного искусственного интеллекта. Принадлежит компании Alphabet, Inc. (Google).